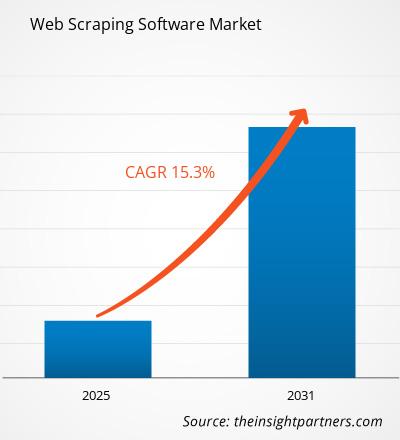

من المتوقع أن يسجل سوق برامج كشط الويب معدل نمو سنوي مركب بنسبة 15.3٪ من عام 2024 إلى عام 2031، مع توسع حجم السوق من XX مليون دولار أمريكي في عام 2024 إلى XX مليون دولار أمريكي بحلول عام 2031.

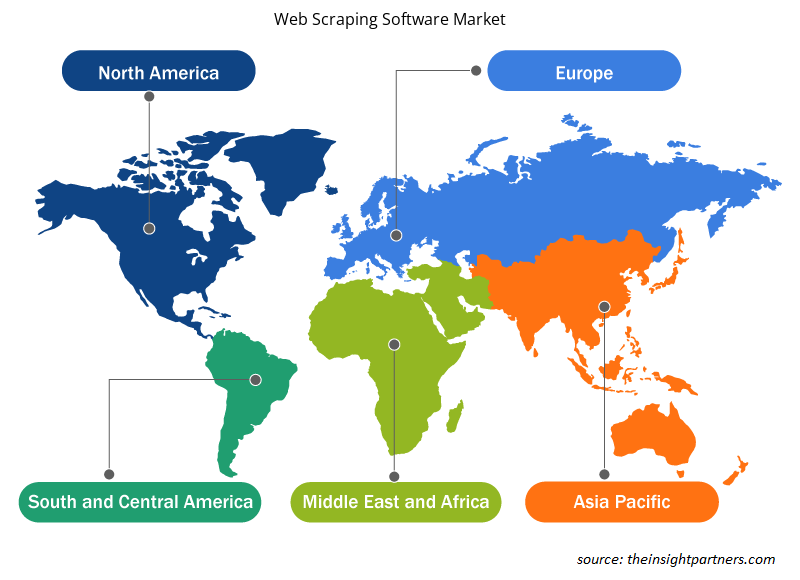

يغطي تقرير سوق برامج كشط الويب التحليل حسب نوع النشر (محليًا، سحابيًا)؛ وحجم المنظمة (المؤسسات الكبيرة، والشركات الصغيرة والمتوسطة الحجم )، والجغرافيا (أمريكا الشمالية، وأوروبا، ومنطقة آسيا والمحيط الهادئ، وأمريكا الجنوبية والوسطى). يتم تقسيم التحليل العالمي بشكل أكبر على المستوى الإقليمي والدول الرئيسية. يقدم التقرير القيمة بالدولار الأمريكي للتحليل والشرائح المذكورة أعلاه.

غرض التقرير

يهدف تقرير سوق برامج كشط الويب الصادر عن The Insight Partners إلى وصف المشهد الحالي والنمو المستقبلي وأهم العوامل الدافعة والتحديات والفرص. سيوفر هذا رؤى لمختلف أصحاب المصلحة في الأعمال التجارية، مثل:

- مزودي/مصنعي التكنولوجيا: لفهم ديناميكيات السوق المتطورة ومعرفة فرص النمو المحتملة، وتمكينهم من اتخاذ قرارات استراتيجية مستنيرة.

- المستثمرون: إجراء تحليل شامل للاتجاهات فيما يتعلق بمعدل نمو السوق، وتوقعات السوق المالية، والفرص المتاحة عبر سلسلة القيمة.

- الهيئات التنظيمية: لتنظيم السياسات ومراقبة الأنشطة في السوق بهدف تقليل الانتهاكات والحفاظ على ثقة المستثمرين ودعم سلامة السوق واستقرارها.

تجزئة سوق برامج كشط الويب

نوع النشر

- في الموقع

- سحاب

حجم المنظمة

- الشركات الكبيرة

- الشركات الصغيرة والمتوسطة

قم بتخصيص هذا التقرير ليناسب متطلباتك

ستحصل على تخصيص لأي تقرير - مجانًا - بما في ذلك أجزاء من هذا التقرير، أو تحليل على مستوى الدولة، وحزمة بيانات Excel، بالإضافة إلى الاستفادة من العروض والخصومات الرائعة للشركات الناشئة والجامعات

- احصل على أهم اتجاهات السوق الرئيسية لهذا التقرير.ستتضمن هذه العينة المجانية تحليلاً للبيانات، بدءًا من اتجاهات السوق وحتى التقديرات والتوقعات.

محركات نمو سوق برامج كشط الويب

- الطلب المتزايد على اتخاذ القرارات المستندة إلى البيانات:

تتخذ الشركات قرارات مستندة إلى البيانات بشكل متزايد، ويلعب استخلاص البيانات من الويب دورًا حاسمًا في جمع كميات كبيرة من البيانات ذات الصلة من مواقع الويب، والتي يمكن تحليلها بعد ذلك لاستخلاص رؤى قابلة للتنفيذ. ومع تزايد توافر البيانات على الويب، تستفيد الشركات من استخلاص البيانات من الويب لتعزيز معلوماتها عن السوق وتحسين عملية اتخاذ القرار والحفاظ على القدرة التنافسية. - نمو التجارة الإلكترونية ومراقبة الأسعار:

أدى نمو قطاع التجارة الإلكترونية إلى زيادة الطلب على أدوات كشط الويب. يستخدم تجار التجزئة ومنصات التجارة الإلكترونية كشط الويب لمراقبة أسعار المنافسين وتتبع قوائم المنتجات وتحليل اتجاهات السوق. أصبحت معلومات الأسعار والمقارنة التنافسية ضرورية للشركات للحفاظ على قدرتها التنافسية، مما يدفع الطلب على برامج كشط الويب. أصبح تحديد المعايير أمرًا ضروريًا للشركات لتظل قادرة على المنافسة، وهو ما يدفع الطلب على برامج كشط الويب. - أتمتة مهام جمع البيانات المتكررة:

تعمل أدوات كشط الويب على أتمتة عملية جمع البيانات من مصادر متعددة، مما يوفر الوقت ويقلل الجهد اليدوي المبذول. تعد هذه الأتمتة مفيدة بشكل خاص للشركات التي تتطلب جمع بيانات واسعة النطاق بشكل منتظم، مثل مراقبة اتجاهات سوق الأوراق المالية، أو تتبع موجزات الأخبار، أو استخراج تفاصيل المنتج من مواقع ويب مختلفة.

الاتجاهات المستقبلية لسوق برامج كشط الويب

- حلول كشط الويب المستندة إلى السحابة:

تكتسب حلول استخراج البيانات من الويب المستندة إلى السحابة شعبية كبيرة بسبب قابليتها للتوسع ومرونتها وانخفاض الاستثمار الأولي. يمكن للشركات الوصول إلى منصات سحابية لاستخراج البيانات من الويب دون الحاجة إلى صيانة البنية الأساسية الخاصة بها، مما يسمح لها بالتركيز على جمع البيانات وتحليلها. كما تتيح هذه الحلول التكامل بشكل أسهل مع أدوات أخرى مستندة إلى السحابة للتحليلات وإعداد التقارير. - استخراج البيانات غير المنظمة:

هناك اتجاه متزايد نحو استخراج البيانات غير المنظمة، مثل الصور ومقاطع الفيديو ومحتوى الوسائط الاجتماعية. وتهتم الشركات بشكل متزايد باستخراج ليس فقط البيانات النصية ولكن أيضًا محتوى الوسائط المتعددة لتطبيقات مثل تحليل المشاعر والتعرف على الصور والاستماع الاجتماعي. وتتكيف أدوات استخراج الويب المتقدمة للتعامل مع هذه الأنواع المتنوعة من البيانات، مما يوسع نطاقها وفائدتها. - التركيز على الاستخلاص الأخلاقي وخصوصية البيانات:

مع تزايد المخاوف بشأن الخصوصية وأمان البيانات، هناك اتجاه متزايد لممارسات الاستخلاص الأخلاقي من الويب. تركز الشركات على استخلاص البيانات بما يتوافق مع القوانين واللوائح مثل GDPR وCCPA.

فرص سوق برامج كشط الويب

- التطبيقات في توليد العملاء واكتساب العملاء:

تُستخدم عملية كشط الويب على نطاق واسع لتوليد العملاء المحتملين، وخاصة من قبل الشركات التي تسعى إلى جمع تفاصيل الاتصال وملفات تعريف الشركة وغيرها من المعلومات ذات الصلة من مواقع الويب مثل منصات الوسائط الاجتماعية وأدلة الأعمال. هناك فرصة متزايدة لبرامج كشط الويب في فرق المبيعات والتسويق التي تركز على بناء العملاء المحتملين واكتساب العملاء. - البحث عن رؤى مالية واستثمارية:

يعتمد قطاع الخدمات المالية بشكل متزايد على أدوات استخراج البيانات من الويب لجمع البيانات في الوقت الفعلي من مواقع الأخبار المالية ومنصات سوق الأوراق المالية ووسائل التواصل الاجتماعي لتحليل السوق وتحليل المشاعر واتخاذ قرارات الاستثمار. يخلق هذا الطلب المتزايد فرصة لمقدمي برامج استخراج البيانات من الويب لاستهداف قطاعي التمويل والاستثمار. - مراقبة وسائل التواصل الاجتماعي وتحليل المشاعر:

تعد منصات التواصل الاجتماعي مصدرًا غنيًا بالبيانات التي يمكن للشركات استخدامها لمراقبة مشاعر العلامة التجارية وتتبع تعليقات العملاء وتحليل سلوك المستهلك. أدوات كشط الويب التي يمكنها كشط محتوى وسائل التواصل الاجتماعي والمراجعات والتعليقات بكفاءة مطلوبة بشدة. وهذا يفتح الفرص لمقدمي برامج كشط الويب لإنشاء حلول لمراقبة وسائل التواصل الاجتماعي وتحليل المشاعر.

رؤى إقليمية حول سوق برامج كشط الويب

لقد قام المحللون في Insight Partners بشرح الاتجاهات والعوامل الإقليمية المؤثرة على سوق برامج استخراج البيانات من الويب طوال فترة التوقعات بشكل شامل. يناقش هذا القسم أيضًا قطاعات سوق برامج استخراج البيانات من الويب والجغرافيا في جميع أنحاء أمريكا الشمالية وأوروبا ومنطقة آسيا والمحيط الهادئ والشرق الأوسط وأفريقيا وأمريكا الجنوبية والوسطى.

- احصل على البيانات الإقليمية المحددة لسوق برامج كشط الويب

نطاق تقرير سوق برامج كشط الويب

| سمة التقرير | تفاصيل |

|---|---|

| حجم السوق في عام 2024 | XX مليون دولار أمريكي |

| حجم السوق بحلول عام 2031 | XX مليون دولار أمريكي |

| معدل النمو السنوي المركب العالمي (2025 - 2031) | 15.3% |

| البيانات التاريخية | 2021-2023 |

| فترة التنبؤ | 2025-2031 |

| القطاعات المغطاة | حسب نوع النشر

|

| المناطق والدول المغطاة | أمريكا الشمالية

|

| قادة السوق وملفات تعريف الشركات الرئيسية |

|

كثافة اللاعبين في سوق برامج كشط الويب: فهم تأثيرها على ديناميكيات الأعمال

يشهد سوق برامج استخراج البيانات من الويب نموًا سريعًا، مدفوعًا بالطلب المتزايد من المستخدم النهائي بسبب عوامل مثل تفضيلات المستهلكين المتطورة والتقدم التكنولوجي والوعي المتزايد بفوائد المنتج. ومع ارتفاع الطلب، تعمل الشركات على توسيع عروضها والابتكار لتلبية احتياجات المستهلكين والاستفادة من الاتجاهات الناشئة، مما يؤدي إلى زيادة نمو السوق.

تشير كثافة اللاعبين في السوق إلى توزيع الشركات أو المؤسسات العاملة في سوق أو صناعة معينة. وهي تشير إلى عدد المنافسين (اللاعبين في السوق) الموجودين في مساحة سوق معينة نسبة إلى حجمها أو قيمتها السوقية الإجمالية.

الشركات الرئيسية العاملة في سوق برامج كشط الويب هي:

- بيانات لتحسين محركات البحث

- ديفبوت

- أنظمة المساعدة

- استيراد.io

- مجرد مثل API

إخلاء المسؤولية : الشركات المذكورة أعلاه ليست مرتبة بأي ترتيب معين.

- احصل على نظرة عامة على أهم اللاعبين الرئيسيين في سوق برامج كشط الويب

نقاط البيع الرئيسية

- التغطية الشاملة: يغطي التقرير بشكل شامل تحليل المنتجات والخدمات والأنواع والمستخدمين النهائيين لسوق برامج كشط الويب، مما يوفر صورة شاملة.

- تحليل الخبراء: تم تجميع التقرير على أساس الفهم العميق لخبراء الصناعة والمحللين.

- معلومات محدثة: يضمن التقرير أهمية الأعمال التجارية بسبب تغطيته للمعلومات الحديثة واتجاهات البيانات.

- خيارات التخصيص: يمكن تخصيص هذا التقرير لتلبية متطلبات العملاء المحددة وبما يتناسب مع استراتيجيات العمل بشكل مناسب.

وبالتالي، يمكن أن يساعد تقرير البحث حول سوق برامج استخراج البيانات من الويب في تمهيد الطريق لفك شفرة وفهم سيناريو الصناعة وآفاق النمو. ورغم وجود بعض المخاوف المشروعة، فإن الفوائد الإجمالية لهذا التقرير تميل إلى التفوق على العيوب.

- التحليل التاريخي (سنتان)، سنة الأساس، التوقعات (7 سنوات) مع معدل النمو السنوي المركب

- تحليل PEST و SWOT

- حجم السوق والقيمة / الحجم - عالمي، إقليمي، بلد

- الصناعة والمنافسة

- مجموعة بيانات إكسل

التقارير الحديثة

تقارير ذات صلة

شهادات العملاء

سبب الشراء

- اتخاذ قرارات مدروسة

- فهم ديناميكيات السوق

- تحليل المنافسة

- رؤى العملاء

- توقعات السوق

- تخفيف المخاطر

- التخطيط الاستراتيجي

- مبررات الاستثمار

- تحديد الأسواق الناشئة

- تحسين استراتيجيات التسويق

- تعزيز الكفاءة التشغيلية

- مواكبة التوجهات التنظيمية

احصل على عينة مجانية ل - سوق برامج كشط الويب

احصل على عينة مجانية ل - سوق برامج كشط الويب